麦青儿 - 2019-6-28 14:16:00

有网友问这张图上的数据是怎么得出来的,转发一下答复:

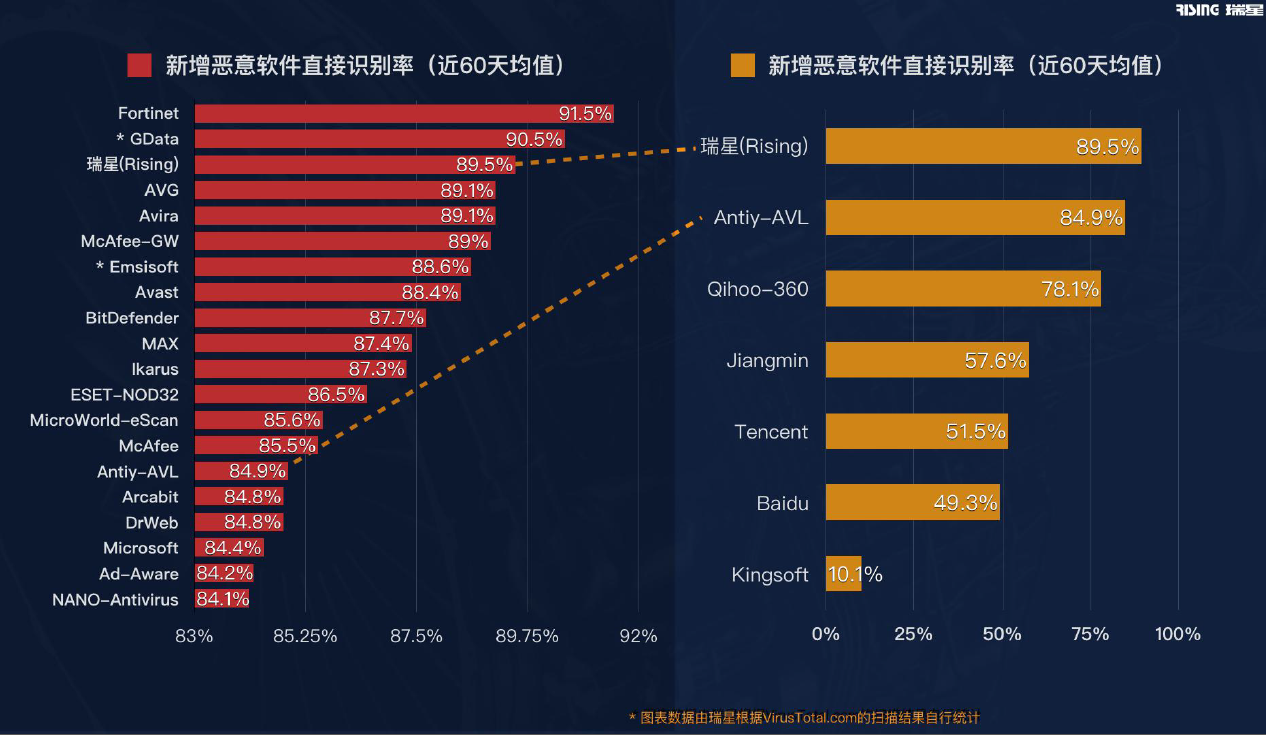

数据是使用VTAPI查询当日新增的SHA256查询扫描结果统计得出的,统计的方法是:以当日至少五家厂商报毒的新增文件作为全集,然后分别计算每个厂商的检出率。为什么只选新增样本做统计?因为对于一个安全厂商来说,识别未曾出现的新增威胁,才是最重要的,要不然云端维护一个巨大的哈希库就可以了,这显得太低级了。

VT是一个公平的舞台,它每天机械性地扫描数百万文件,其中新增恶意软件数十万,而且无论从样本的全面性、数量、及时性以及是扫描过程的不可操纵性,都比只有几百个样本的评测得出的结果来得靠谱,再加上长期地持续地数据监测后得出均值,也更能真实地反映厂商的检测能力。另外,VT还有误报和独报的数据统计,而且是公开的,综合来看,VT是检验安全厂商恶意软件识别能力非常理想的统计数据来源。

瑞星提供的这份统计数据涉及到的样本量在百万级(每天数十万,一共60天),结果是真实的,所以才会很坦然的公布。如果各位小伙伴觉得自己支持的厂商在数据上不好看,可以鼓励你支持的厂商把全能力放到VT上,我们很希望看到中国的反病毒公司们可以一起长期保持全球恶意软件检测能力的领先。

瑞星在VT使用的反病毒引擎,确实还未完全同步到各个产品中,目前最接近的,应该是瑞星的硬件产品中使用的反病毒引擎,例如:新的硬件安全产品-TSA和沙箱。新增的能力,也就是让瑞星检出率飞涨的体系,是在2016~2018年期间打造的,主要的技术是 代码主干模糊哈希 和 机器学习。这两种技术,都是全自动运营的,基本没什么人参与,所以每天数十万数百万的新增样本,都可以被消化完(人工根本无法做到,所以有些厂商会有这种理由辩解),对于原来提取病毒特征串的那些病毒分析员来说,可以说是”躺杀“了。其中,代码主干模糊哈希技术,几乎覆盖了所有的文件类型,PE啊,ELF啊,各种脚本啊,各类文档啊等等,而机器学习部分,主要还是针对PE/SWF/PDF(脚本的误报高一直没用)。两种技术在云端和本地都有应用,只不过云端的数据库和模型更大,结果更加可靠,而本地的则受制于空间限制,数据量和模型都很小。

现在,这些能力,已经分别通过 瑞星反病毒引擎SDK 和 ”云脑“(云引擎)WEB-API直接向外界提供,可以帮助各类厂商迅速获得全球领先的恶意软件检测能力:)

欢迎垂询~~~

数据是使用VTAPI查询当日新增的SHA256查询扫描结果统计得出的,统计的方法是:以当日至少五家厂商报毒的新增文件作为全集,然后分别计算每个厂商的检出率。为什么只选新增样本做统计?因为对于一个安全厂商来说,识别未曾出现的新增威胁,才是最重要的,要不然云端维护一个巨大的哈希库就可以了,这显得太低级了。

VT是一个公平的舞台,它每天机械性地扫描数百万文件,其中新增恶意软件数十万,而且无论从样本的全面性、数量、及时性以及是扫描过程的不可操纵性,都比只有几百个样本的评测得出的结果来得靠谱,再加上长期地持续地数据监测后得出均值,也更能真实地反映厂商的检测能力。另外,VT还有误报和独报的数据统计,而且是公开的,综合来看,VT是检验安全厂商恶意软件识别能力非常理想的统计数据来源。

瑞星提供的这份统计数据涉及到的样本量在百万级(每天数十万,一共60天),结果是真实的,所以才会很坦然的公布。如果各位小伙伴觉得自己支持的厂商在数据上不好看,可以鼓励你支持的厂商把全能力放到VT上,我们很希望看到中国的反病毒公司们可以一起长期保持全球恶意软件检测能力的领先。

瑞星在VT使用的反病毒引擎,确实还未完全同步到各个产品中,目前最接近的,应该是瑞星的硬件产品中使用的反病毒引擎,例如:新的硬件安全产品-TSA和沙箱。新增的能力,也就是让瑞星检出率飞涨的体系,是在2016~2018年期间打造的,主要的技术是 代码主干模糊哈希 和 机器学习。这两种技术,都是全自动运营的,基本没什么人参与,所以每天数十万数百万的新增样本,都可以被消化完(人工根本无法做到,所以有些厂商会有这种理由辩解),对于原来提取病毒特征串的那些病毒分析员来说,可以说是”躺杀“了。其中,代码主干模糊哈希技术,几乎覆盖了所有的文件类型,PE啊,ELF啊,各种脚本啊,各类文档啊等等,而机器学习部分,主要还是针对PE/SWF/PDF(脚本的误报高一直没用)。两种技术在云端和本地都有应用,只不过云端的数据库和模型更大,结果更加可靠,而本地的则受制于空间限制,数据量和模型都很小。

现在,这些能力,已经分别通过 瑞星反病毒引擎SDK 和 ”云脑“(云引擎)WEB-API直接向外界提供,可以帮助各类厂商迅速获得全球领先的恶意软件检测能力:)

欢迎垂询~~~